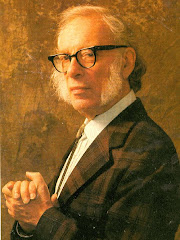

Los investigadores en inteligencia artificial a menudo idealizan las Leyes de la Robótica de Isaac Asimov como indicadores de la interacción robot-humano. Pero algunos expertos en robótica dicen que la idea podría usar una remodelación práctica para reconocer las actuales limitaciones de los robots.

Los investigadores en inteligencia artificial a menudo idealizan las Leyes de la Robótica de Isaac Asimov como indicadores de la interacción robot-humano. Pero algunos expertos en robótica dicen que la idea podría usar una remodelación práctica para reconocer las actuales limitaciones de los robots.

Los robots auto-conscientes que habitan las historias de Asimov y otras tales como “2001: Odisea en el Espacio” y “Battlestar Galactica” siguen en el futuro lejano. Los robots actuales aún carecen de cualquier tipo de autonomía real para tomar sus propias decisiones o adaptarse inteligentemente a nuevos entornos.

Pero el peligro surge cuando los humanos empujan a los robots más allá de sus actuales límites de toma de decisiones, advierten los expertos. Esto puede llevar a errores e incluso a tragedias implicando a robos en fábricas o en operaciones militares, cuando los humanos olvidan que toda la responsabilidad ética y legal aún descansa sobre los hombros del homo sapiens.

“La fascinación por los robots ha llevado a alguna gente a tratar de evitar la responsabilidad de decisiones complejas, con consecuencias potencialmente malas”, dijo David Woods, ingeniero de sistemas en la Universidad Estatal de Ohio.

Woods y un compañero investigador propusieron revisar las Tres Leyes para enfatizar la responsabilidad humana sobre los robots. También sugirieron que los manejadores de los robots en Tierra podrían tomar pistas de la NASA cuando se trata de interacción robot-humano.

Actualizando a Asimov

Las Tres Leyes de Asimov están fijadas en un futuro en el que los robots pueden pensar y actuar por sí mismos. La primera ley prohíbe que los robots dañen a los humanos o que los humanos queden dañados por inacción, la segunda ley requiere que los robots obedezcan las órdenes de los humanos salvo que entre en conflicto con la primera ley. La tercera ley requiere que los robots protejan su propia existencia, excepto cuando hacer esto entre en conflicto con las dos leyes anteriores.

Corea del Sur ha usado estas “leyes” como una guía para su Carta de Ética Robótica, pero Woods y sus colegas creen que carecen de algunos puntos vitales.

Woods trabajó junto con Robin Murphy, experto en robótica de rescate de la Universidad Texas A&M, para crear tres leyes que reconozcan a los humanos como los adultos inteligentes responsables de las relaciones robot-humano. Su primera ley dice que los humanos no deben desplegar robots sin un sistema de trabajo que cumpla con los mayores estándares profesionales y legales de seguridad y ética. Una segunda ley revisada requiere que los robots respondan a los humanos de forma adecuada a sus papeles, y se asume que los robots están diseñados para responder a ciertas órdenes de un número limitado de humanos.

La tercera ley revisada propone que los robots deben tener suficiente autonomía para proteger su propia existencia, siempre que tal protección no entre en conflicto con las dos leyes anteriores y permita una transferencia suave de control entre humano y robot. Esto significa que el róver de Marte debería saber automáticamente que no debe ir hacia un acantilado, salvo que los operadores humanos le digan específicamente que lo haga.

Woods y Murphy ven necesaria tal revisión dado que los fabricantes de robots no reconocen la responsabilidad humana sobre los robots. Murphy dijo que tal actitud procede de la cultura del software de ordenador, donde la responsabilidad conlleva menos consecuencias que crear una máquina la cual termine hiriendo a los humanos o dañando una propiedad.

“Lo que sucede es que vemos a robotistas que nunca han fabricado o trabajado en el mundo físico, y no se dan cuenta de que son los responsables”, dijo Murphy a SPACE.com. “Al final del día, si haces algo, es tu problema”.

Esto contrasta con la actitud de la “cultura de la seguridad” de la NASA y la aproximación metódica que prueba cuidadosamente los róvers y sondas robóticas, reconoce los límites de los robots e intenta asegurar que los operadores humanos puedan saltar rápidamente al asiento del conductor cuando sea necesario.

El camino de la NASA

Tanto Woods como Murphy dijeron que se sienten muy cómodos con la aproximación de la NASA a las interacciones robot-humano, ya sea implicando a brazos robóticos en la Estación Espacial Internacional o a la sonda Cassini haciendo su tour por el sistema de Saturno.

“Comprenden cómo de valiosos son los recursos robóticos”, explicó Woods. “Saben que habrá sorpresas en la exploración espacial”.

Murphy señala que la aproximación de la NASA a los robots procede de la tradición de IA donde la gente no hace suposiciones sobre tener un control perfecto sobre todo. El lugar de esto, la agencia espacial ha usado sistemas de IA que pueden funcionar bien dentro de los patrones normales de operación, y aún así pueden depender de asistencia humana para las situaciones más inciertas.

Esta aproximación ha funcionado bien en el caso de la NASA en muchas ocasiones. Por ejemplo, los científicos han hecho hábiles maniobras con los róvers de Marte Spirit y Opportunity, cuando los robots encuentran problemas impredecibles en el terreno y clima marciano.

Por el contrario, algunos investigadores sin un trasfondo de IA asumen que pueden programar robots que tengan un modelo o visión completa del mundo, y que pueden comportarse adecuadamente para cualquier situación dada. Esto coincide con la tentación de suponer que dar a los robots más autonomía significa que pueden manejar la mayor parte, o todas, las situaciones por sí mismos.

Murphy advirtió que tal aproximación de “mundo cerrado” sólo funciona en ciertas situaciones que presentan opciones limitadas para una IA. No importa cuánta programación incluyan los robots, el mundo real abierto representa un agujero lleno de trampas y escenarios inesperados.

Transferencia de control

La NASA indudablemente aún quiere ver que los robots pueden tomar más responsabilidad, especialmente durante misiones cuando las sondas viajan más allá de la Luna o Marte. Los investigadores han empezado a desarrollar la siguiente generación de robots que podrían algún día tomar las decisiones más básicas al explorar mundos como Europa o Titán.

Pero por ahora, la NASA ha reconocido que los robots aún necesitan supervisión humana – un concepto que algunos fabricantes y operadores de la Tierra tienen problemas para aceptar. Situaciones inesperadas tales como un mal funcionamiento del robot o sorpresas ambientales que pueden requerir que los humanos recobren rápidamente el control del robot, por un fallo a la respuesta correcta.

“Ahora mismo, lo que vemos una y otra vez es que transferir el control es un problema”, señala Murphy. Observa cómo los operadores humanos rápidamente entran en problemas al manejar robots en “Disaster City” de Texas A&M”, un área de simulación de entrenamiento para rescate. Parte del problema también surge cuando la gente no sabe las capacidades de su robot.

La NASA se permite el lujo de tener un equipo de científicos vigilando sus exploradores robóticos, en lugar de sólo operadores humanos. Pero los controladores de misión también mantienen una alta conciencia de los límites de sus exploradores robóticos, y saben cómo tomar suavemente el control.

“Comprenden que cuando tienen seguridad o bajo riesgo, pueden delegar más autonomía en el robot”, dijo Woods. “Cuando pasan cosas inusuales, restringen la autonomía”.

Woods comparó la situación a los padres que colocan un perímetro de seguridad dentro del cual los niños pueden explorar. Esta analogía puede continuar sirviendo tanto para la NASA como para otros manejadores de robots.

“La gente está dando este salto de fe sobre que la autonomía de los robots aumentará y resolverá nuestros problemas”, añade Woods. “Pero no hay muchas pruebas sobre que la autonomía por sí misma eliminarán estas decisiones difíciles y de alto riesgo”.